多模态数据集

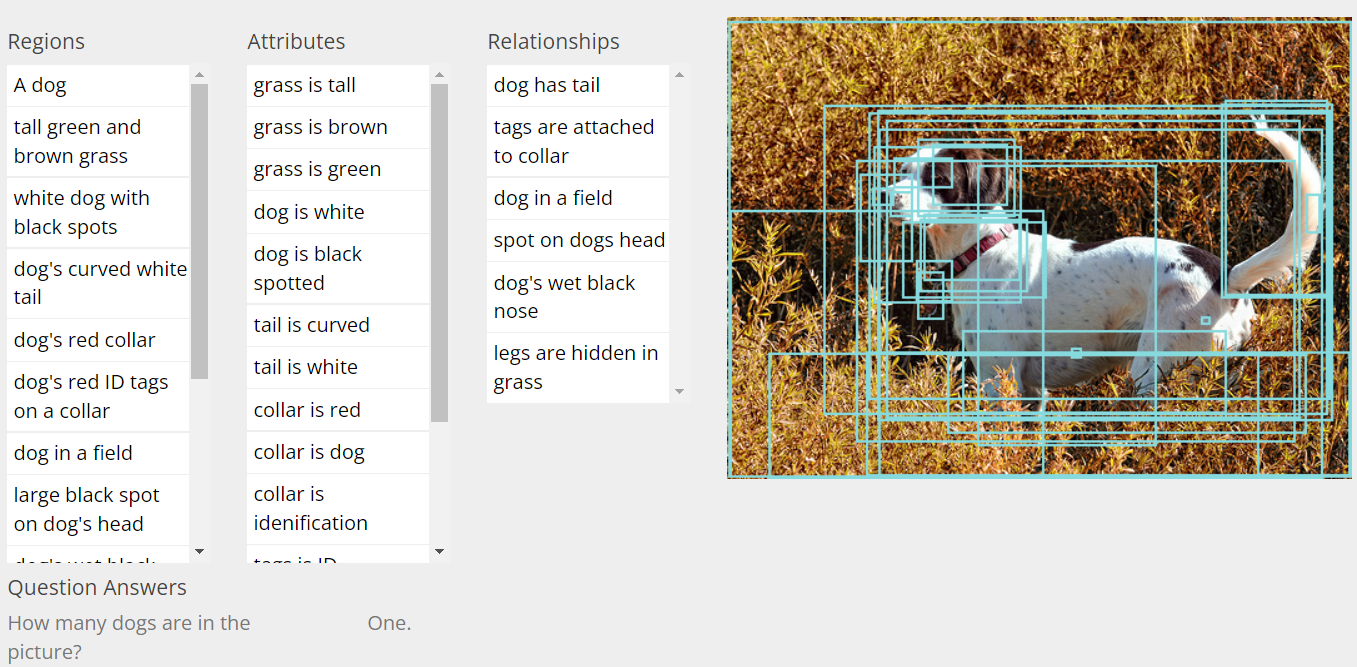

| 名称 | 数据量 | 数据来源 | 制作团队 | 主要用途 | 备注 |

|---|---|---|---|---|---|

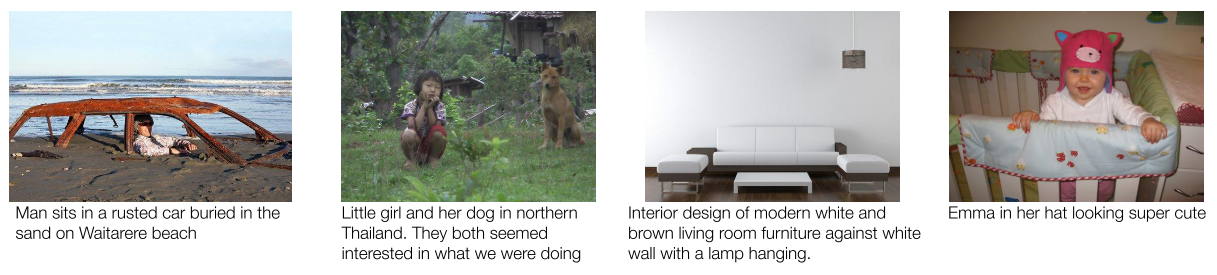

| COCO Captions | 330K images, >1650K captions |

Flickr, AMT annotation | Microsoft | Image Captioning | 每个样本5条描述,test c40中每个样本40条描述 图像收集遵循先选类别后搜索的逻辑 |

| Flickr30K | 32K images, 159K captions |

Flickr, AMT annotation | University of Illinois at Urbana-Champaign |

Image Captioning | 每个样本5条描述 有个早期的小规模版本Flickr8k |

| WebImageText | 400M image-text pairs |

Web images | OpenAI | Image Captioning, Pre-training |

CLIP论文为预训练收集的数据集 从500000个候选词中查询,每次查询最多拿20,000个样本 |

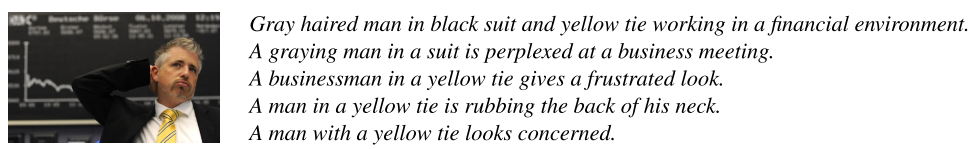

| Visual Genome | 108K images, 5.4M region descriptions |

YFCC100M & MS-COCO, AMT annotation |

Stanford University | Scene Graph VQA |

每张图超过42条信息,以及平均17条VQA问答 |

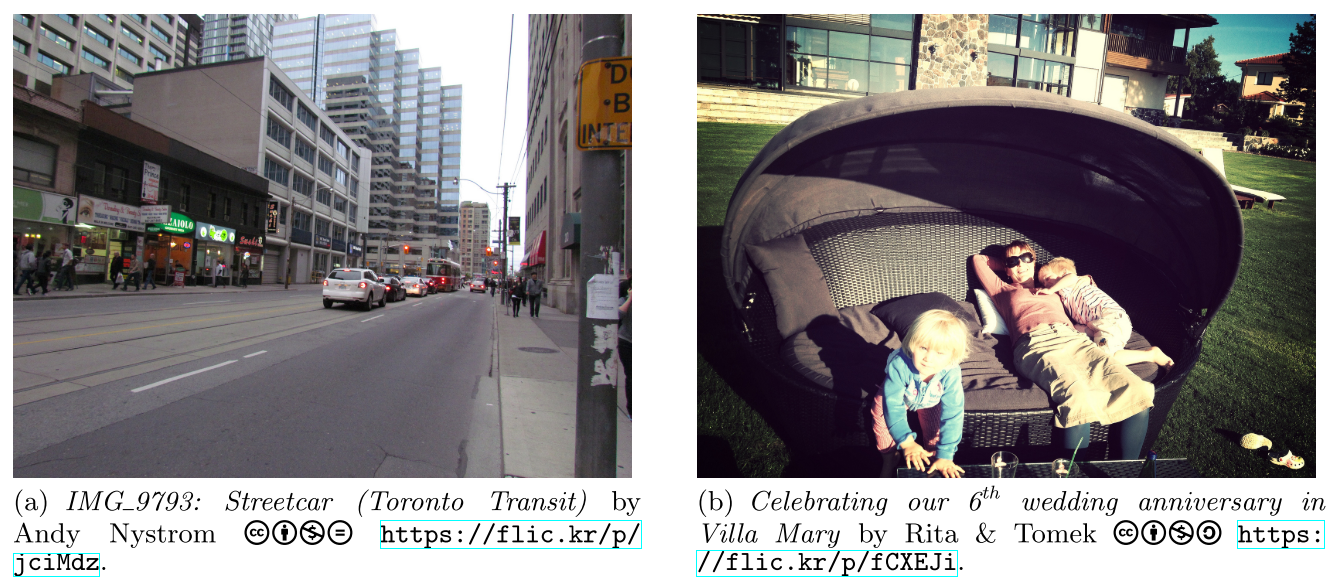

| YFCC100M | 99.2M images 0.8M videos |

Flickr metadata | Yahoo | Image Captioning Pre-training |

数据集以metadata的形式发布,仅metadata就超过12.5GB, 具体图片需要根据链接下载 |

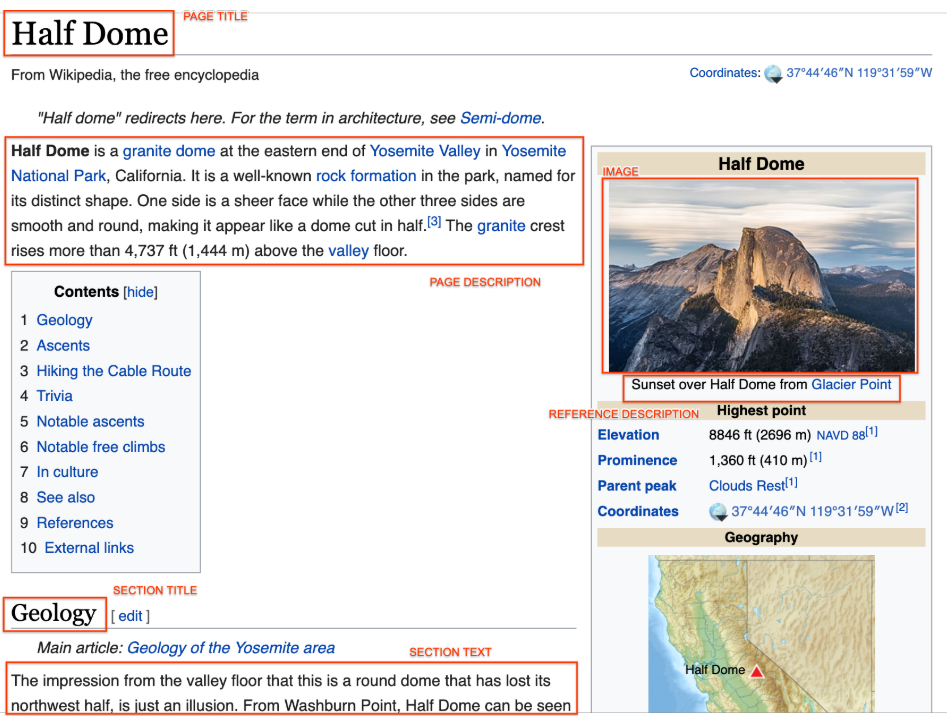

| WIT Wikipedia-based Image Text |

11.5M images 37.6M text |

Wikipedia | Image Captioning Pre-training |

比较新,2021公开的 | |

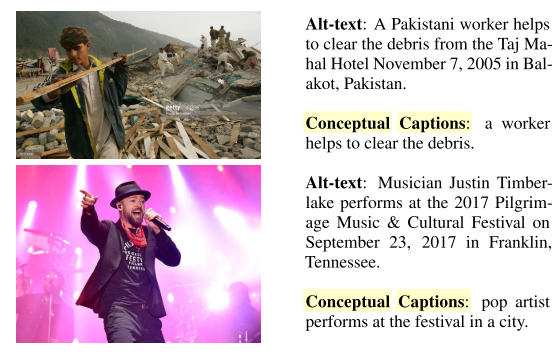

| Conceptual Captions | 3.3M image-text pairs | Web images and alt-text, filtering |

Image Captioning | 2021几篇比较出名的工作都用这个做预训练 | |

| SBU Captions | 1M image-text pairs | Flickr, filter | Stony Brook University | Image Captioning | 比较早期的工作,2011年 |

| Speaker/EnvDrop | 178K path-instruction pairs |

Matterport, synthetic | UC Berkeley, CMU, BU |

VLN augmentation | |

| BnB | 1.4M images 0.7M text |

Airbnb, caption rephrasing or speaker |

PSL Research University | VLN pre-train | 在一个在线看房网站收集的室内场景图像-描述对 AirBERT使用的数据集 |

MS-COCO captions

Flickr30K

WebImageText(未公开)

Visual Genome

YFCC100M

WIT

Conceptual Captions

SBU Captions